- Digitalisierung & Modernisierung

Informationsbeschaffung im Zeitalter von KI

HR-Wissen auf Knopfdruck: Ein RAG Chatbot als intelligenter Assistent bei Lufthansa Group Business Services

vonJohannes Ridinger | Lufthansa Group Business Services GmbH

Adobe Stock / Sai

Die Meinungen zum Thema Künstliche Intelligenz (KI) bewegen sich zwischen enthusiastischen Zukunftsvisionen und dystopischen Warnungen vor möglichen Gefahren und Fehlern der Technologie. Doch wo bietet KI derzeit bereits einen echten Mehrwert? Einer dieser Bereiche ist die Suche und Aufbereitung von Informationen, insbesondere in Fachgebieten mit umfangreichen Dokumentationen. Große, KI-basierte Sprachmodelle (LLMs) haben das Potenzial, die Art und Weise, wie wir mit Wissen interagieren, grundlegend zu verändern. Johannes Ridinger (Lufthansa Group Business Services GmbH, Hamburg) erläutert einen Anwendungsfall.

Seit dem fulminanten Aufstieg von ChatGPT ist Künstliche Intelligenz (KI) in aller Munde. Die Diskussionen reichen von enthusiastischen Zukunftsvisionen bis hin zu kritischen Stimmen, die vor den möglichen Gefahren und Fehlern der Technologie warnen. Während der Hype um KI teilweise übertrieben scheint und es sicherlich Anwendungsfälle gibt, in denen traditionelle Methoden überlegen sind, gibt es auch Bereiche, in denen KI einen echten Mehrwert bieten kann.

Einer dieser Bereiche ist die Suche und Aufbereitung von Informationen, insbesondere in Fachgebieten mit umfangreichen Dokumentationen. Große Sprachmodelle (LLMs) haben das Potenzial, die Art und Weise, wie wir mit Wissen interagieren, grundlegend zu verändern. Anstatt sich auf traditionelle, oft zeitaufwendige und ineffiziente Methoden wie die reine Textsuche zu verlassen, können LLMs dabei helfen, relevante Informationen schnell und präzise zu identifizieren und aufzubereiten bzw. sogar schon zu interpretieren.

Dieser vielversprechende Anwendungsfall zeigt, dass KI, jenseits des Hypes, bereits heute einen konkreten Mehrwert für Mitarbeiter und Unternehmen bieten kann, indem sie den Zugang zu Wissen erleichtert und beschleunigt. So müssen Mitarbeiter im HR-Bereich beispielsweise nicht mehr mühsam nach Stichwörtern suchen, den entsprechenden Abschnitt in einem umfangreichen Handbuch finden und dann die Informationen auf ihre spezifische Situation anwenden und interpretieren. Stattdessen können sie ihre Frage direkt an einen Chatbot stellen. Dieser Chatbot wurde mit der gesamten Dokumentation des Bereiches Abrechnung vertraut gemacht und kann eine direkte und präzise Antwort liefern, die auf die individuellen Bedürfnisse des Mitarbeiters zugeschnitten ist. Dabei wird das RAG-Konzept (Retrieval Augmented Generation)1 eingesetzt, um große Sprachmodelle wie GPT 3.5 oder GPT 4, bekannt geworden durch ChatGPT, mit der Fähigkeit zu kombinieren, gezielte Informationen aus externen Quellen abzurufen, um somit präzisere und faktenbasierte Antworten zu generieren. Damit wird das Sprachmodell nicht auf sein trainiertes Wissen beschränkt, sondern mit einem Retriever für zusätzliche Informationen verknüpft, der für jede Query die passendsten Ausschnitte aus der externen Quelle heraussucht.

LLM-gestützte Chatbots: Mehr als nur Informationsbeschaffung

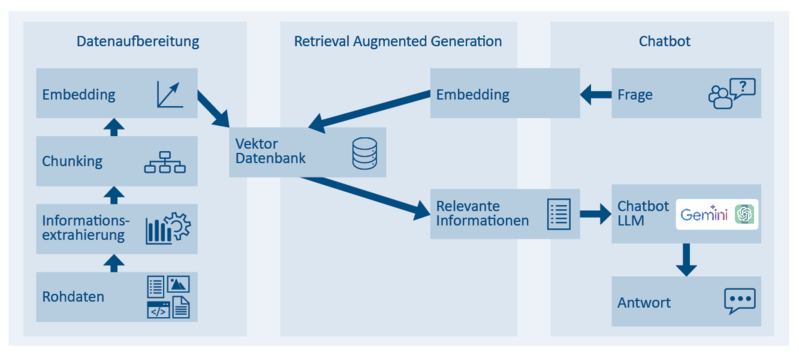

Vergleicht man diese RAG Chatbots mit den bisher üblichen regelbasierten Chatbots, fällt direkt die Flexibilität und Anpassungsfähigkeit auf. Während regelbasierte Chatbots, z. B. im Kundenservice, bisher auf bestimmte Wörter oder Sätze programmiert waren und nur dann eine Antwort geben, wenn dies ihr Regelwerk zulässt, können die RAG Chatbots mithilfe der riesigen Sprachmodelle die Anfrage viel besser interpretieren und somit auch ohne die Erstellung eines umfassenden Regelwerks mithilfe des Retrieval-Prozesses passgenaue Antworten bieten. Dadurch werden diese Limits des Regelwerks gesprengt und es muss nicht jeder Einzelfall vorher definiert werden. Während die traditionellen Chatbots in einigen Fällen immer noch ihre Berechtigung haben, wo z. B. fest definierte Regeln von hoher Bedeutung sind, bieten sich Sprachmodell-gestützte RAG Chatbots deutlich besser für konversationsgetriebene Anwendungsfälle wie im Kundenservice an.2 Ein Beispiel für die grobe Funktionsweise ist in Abbildung 1 dargestellt.

Abb. 1: Beispiel für die grobe Funktionsweise eines RAG Chatbots (Quelle: eigene Darstellung)

Die Vorzüge dieser RAG Chatbots reichen weit über die Suche nach Informationen hinaus. Dank ihrer fortschrittlichen Sprachverarbeitungstechnologie können sie Anfragen in verschiedenen Sprachen verstehen und beantworten, selbst wenn die zugrunde liegende Dokumentation nur auf Deutsch vorliegt. Diese mehrsprachige Kompetenz fördert die Inklusion und erleichtert die Kommunikation in internationalen Unternehmen, in denen Mitarbeiter unterschiedliche Muttersprachen haben. Ein weiterer entscheidender Vorteil liegt in der Möglichkeit, die Antworten des Chatbots gezielt zu steuern. So können HR-Mitarbeiter beispielsweise vordefinierte Antwortformulierungen erstellen, um sicherzustellen, dass die Informationen verständlich, einheitlich und im Einklang mit den Unternehmensrichtlinien kommuniziert werden. Dies gewährleistet nicht nur eine hohe Qualität der Antworten, sondern entlastet auch die HR-Abteilung, da sie nicht jede Anfrage individuell bearbeiten muss.

Insbesondere neue Mitarbeiter profitieren erheblich von einem solchen Chatbot. Sie können sich selbstständig Wissen aneignen und schneller in ihre Aufgaben hineinwachsen, anstatt ihre Kollegen mit Fragen zu beanspruchen, was den Zeitaufwand für alle Beteiligten reduziert und die Einarbeitung beschleunigt.

Technische Umsetzung: Vom Handbuch zur KI-gestützten Antwort

Die Implementierung des RAG Chatbots bei der Lufthansa Group Business Services erforderte eine sorgfältige technische Umsetzung, um sicherzustellen, dass das Payroll-Handbuch, das auf einem internen, geschützten Bereich der Intranet-Webseite liegt, für den Chatbot zugänglich und nutzbar gemacht wird.

Da das Handbuch nicht direkt in einer maschinenlesbaren Form vorlag, war der erste Schritt das sogenannte „Scraping“. Dabei wird die Webseite, auf der das Handbuch liegt, automatisiert durchsucht und die relevanten Inhalte extrahiert. Anschließend wurden die extrahierten Informationen mithilfe von fortschrittlichen NLP-Techniken (Natural Language Processing) in eine Vektor-Datenbank umgewandelt. Jeder Abschnitt oder Absatz des Handbuchs wird dabei in einen multidimensionalen Vektor transformiert. Diese Vektoren sind mathematische Darstellungen, die die Bedeutung und den Kontext der Wörter erfassen. Ähnlich bedeutende Wörter haben Vektoren, die im Vektorraum nahe beieinander liegen. Dadurch können Modelle wie RAG Chatbots die semantischen Beziehungen zwischen Wörtern verstehen und nutzen, um relevante Informationen abzurufen und kontextbezogene Antworten zu generieren.3

Gibt es z. B. mehrere Informationen über Altersteilzeit und mehrere über Krankengeld, so sehen die Vektoren innerhalb eines Themas viel ähnlicher aus als im Vergleich zu anderen Themen. Stellt nun ein Nutzer eine Frage an den Chatbot, wird diese ebenfalls in einen Vektor umgewandelt. Die Vektor-Datenbank wird dann mittels einer „Similarity Search“ durchsucht, um die Abschnitte des Handbuchs zu identifizieren, deren Vektoren die größte Ähnlichkeit mit dem Anfragevektor aufweisen. Ist diese Frage beispielsweise zum Thema Krankengeld, weist der Vektor der Frage eine deutlich höhere Ähnlichkeit zu den Informationen aus diesem Thema aus, als zu denen aus anderen Themen und somit werden diese Informationen dann an das Sprachmodell übermittelt. Das Sprachmodell kombiniert nun sein allgemeines Sprachverständnis mit dem spezifischen Kontext aus dem Handbuch, um eine präzise und informative Antwort auf die Benutzeranfrage zu generieren. Dieser Prozess ermöglicht es dem Chatbot, auch komplexe Fragen zu beantworten, die ein tiefes Verständnis des Payroll-Handbuchs erfordern, und geht weit über die Möglichkeiten einer einfachen Stichwortsuche hinaus.

Microservices für Flexibilität und Skalierbarkeit

Um die vielfältigen Anforderungen eines modernen Chatbot-Systems zu erfüllen, setzt die Lufthansa Group Business Services auf eine Microservice-Architektur. Dabei wird die Anwendung in eine Reihe kleiner, unabhängiger Dienste aufgeteilt, die jeweils eine spezifische Funktion erfüllen. Diese Microservices kommunizieren über standardisierte Schnittstellen miteinander und können unabhängig voneinander entwickelt, bereitgestellt und skaliert werden.

Diese Architektur bietet zahlreiche Vorteile. Erstens ermöglicht sie eine hohe Skalierbarkeit: Wenn die Nachfrage nach dem Chatbot steigt, können einzelne Microservices gezielt erweitert werden, ohne das gesamte System zu beeinträchtigen. Zweitens fördert sie die Multimodalität: Durch die Integration verschiedener Microservices kann der Chatbot nicht nur Text, sondern auch andere Medien wie Bilder oder Videos verarbeiten und in seine Antworten einbinden. Drittens bietet die Microservice-Architektur große Freiheit bei der Wahl der Technologien: Jeder Microservice kann in der Programmiersprache und mit den Frameworks entwickelt werden, die für seine spezifische Aufgabe am besten geeignet sind. Dies gilt auch für zentrale Komponenten wie das LLM oder die Vektor-Datenbank, die bei Bedarf ausgetauscht oder aktualisiert werden können, ohne dass andere Teile des Systems angepasst werden müssen. So bleibt das System flexibel und kann sich an neue technologische Entwicklungen oder veränderte Anforderungen anpassen. Dies ermöglicht es dem Entwicklungsteam, stets auf dem neuesten Stand der Technik zu bleiben und innovative Lösungen zu implementieren.

Implementierung: Agilität und Geschwindigkeit bei gleichzeitiger Gewährleistung von Compliance und Sicherheit

Die Implementierung des RAG Chatbot-Projekts erfolgte unter dem Leitgedanken der Agilität, um flexibel auf neue Anforderungen und die sich dynamisch entwickelnde technologische Landschaft im Bereich KI und LLMs reagieren zu können. Kurze Entwicklungszyklen und regelmäßige Feedbackschleifen ermöglichten es dem Team, schnell auf Veränderungen zu reagieren und den Chatbot kontinuierlich zu verbessern.

Trotz des agilen Ansatzes wurde von Anfang an großer Wert auf Compliance und Sicherheit gelegt. Datenschutzrechtliche Aspekte wurden sorgfältig geprüft und entsprechende Maßnahmen implementiert, um den Schutz personenbezogener Daten zu gewährleisten. So sollen ohne Zustimmung des Betriebsrates keine Informationen dauerhaft gespeichert werden. Zudem wurden Sicherheitsmechanismen integriert, um unbefugten Zugriff auf das System und die sensiblen HR-Daten zu verhindern. Der Zugriff funktioniert dabei unkompliziert über den Unternehmens-Microsoft-Login.

Der Projektstart verlief reibungslos und effizient, da mehrere Kollegen mit unterschiedlichen Fachkenntnissen parallel an den verschiedenen Bestandteilen arbeiteten. Backend-Entwickler kümmerten sich um die Implementierung der Chatbot-Logik und die Anbindung an die Vektor-Datenbank. Frontend-Designer gestalteten eine intuitive und benutzerfreundliche Oberfläche, während KI-Experten die Kommunikation mit dem LLM und die Antwortgenerierung optimierten.

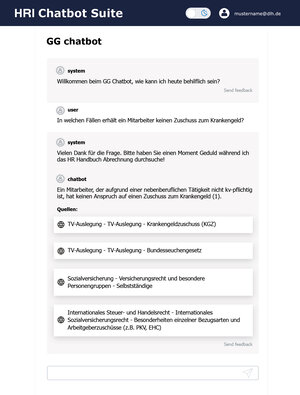

Abb. 2: Beispielfrage in der Konzeptversion des Chatbots (Quelle: eigene Darstellung)

Aktuell befindet sich der Chatbot in einer intensiven Testphase, in der die Fachabteilung ihn auf Herz und Nieren prüft. Die Abbildung 2 zeigt eine Beispielfrage in der derzeitigen Benutzeroberfläche. Neben der Antwort wird auch die Quelle angegeben und mit einem Klick kann auf die Originalseite weitergeleitet werden, um die Informationen zu überprüfen. Dabei wird nicht nur die Funktionalität, sondern auch die Benutzerfreundlichkeit und die Qualität der Antworten evaluiert. Parallel dazu werden die notwendigen Voraussetzungen für den Live-Gang geschaffen, wie Abstimmungen mit dem Betriebsrat und dem Konzern-IT-Ausschuss, um sicherzustellen, dass der Chatbot allen rechtlichen und sicherheitstechnischen Anforderungen entspricht.

Sobald diese Prozesse abgeschlossen sind, soll der Chatbot ausgerollt werden. Die HR-Mitarbeiter des Bereiches Abrechnung können dann von den zahlreichen Vorteilen des Chatbots profitieren, wie der schnellen und präzisen Informationsbeschaffung, der mehrsprachigen Kompetenz und der gezielten Steuerung der Antworten.

Ausblick: Ein universeller Wissensnavigator

Die erfolgreiche Implementierung des RAG Chatbots für das Payroll-Handbuch ist erst der Anfang. Bei der Lufthansa Group Business Services wird bereits über weitere Einsatzmöglichkeiten dieser Technologie nachgedacht und es wurden sogar schon Projekte gestartet, die auf derselben Basis aufbauen. Ziel ist es, den Chatbot zu einer universellen Lösung zu entwickeln, bei der die Wissensbasis je nach Bedarf einfach ausgetauscht werden kann. So könnte der Chatbot in Zukunft auch auf andere Dokumentationen oder Dokumente zugreifen und Mitarbeitern in verschiedenen Bereichen des Unternehmens schnelle und präzise Antworten liefern.

Auch der Chatbot für das Payroll-Handbuch wird kontinuierlich weiterentwickelt. Geplant sind beispielsweise die Integration weiterer Datenquellen, um noch umfassendere Informationen bereitstellen zu können, sowie die Implementierung neuer Funktionen, die die Benutzerfreundlichkeit und Effizienz weiter steigern.

Langfristig soll der Chatbot zu einem zentralen Bestandteil der Wissenskultur bei Lufthansa Group Business Services werden und Mitarbeiter dabei unterstützen, Informationen schnell und maßgerecht zu erhalten.

Jenseits des Payroll-Handbuchs: Die Zukunft der KI-gestützten Wissensnavigation

Der Einsatz von KI-gestützten Chatbots, wie er bei der Lufthansa Group Business Services erfolgreich demonstriert wurde, markiert einen Wendepunkt in der Art und Weise, wie Unternehmen Informationen verwalten und zugänglich machen. Diese innovative Technologie ermöglicht es, komplexe Dokumentationen wie das Abrechnungshandbuch in eine interaktive und leicht zugängliche Wissensquelle zu verwandeln. Mitarbeiter profitieren von einer schnellen und präzisen Informationsbeschaffung, unabhängig von ihrer Muttersprache, und die HR-Abteilung wird von Routineaufgaben entlastet.

Die agile Implementierung des Projekts bei gleichzeitiger Berücksichtigung von Compliance und Sicherheit unterstreicht, dass Innovation und Verantwortungsbewusstsein Hand in Hand gehen können. Der Blick in die Zukunft zeigt das enorme Potenzial dieser Technologie: Die Lufthansa Group Business Services plant bereits weitere Projekte, um den Chatbot auf andere Bereiche auszuweiten und ihn zu einer universellen Wissenslösung zu entwickeln.

KI-gestützte Chatbots sind nicht nur eine technische Innovation, sondern ein Werkzeug, das die Art und Weise, wie wir in Unternehmen lernen, kommunizieren und zusammenarbeiten, grundlegend verändern kann. Sie ebnen den Weg für eine neue Ära der Wissenskultur, in der Informationen nicht mehr nur passiv konsumiert, sondern aktiv genutzt werden, um Innovationen voranzutreiben und die Effizienz im Unternehmen zu steigern.

1 Patrick Lewis et al.: Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks, 08.12.2020, S. 2, online.

2 Nishchit: ChatGPT vs Traditional Chatbots: Core Differences, 29. Februar 2023, online.

3 Tomas Mikolov et al.: Distributed Representations of Words and Phrases and their Compositionality, in: Christopher John C. Burges et al. (Hg.): Advances in Neural Information Processing Systems 26 (NIPS 2012), Lake Tahoe 2012, S. 1.

Weitere Meldungen

Erfolgreiche Webkonferenz der Projektgruppe „Zuwendungspraxis“

- Digitalisierung & Modernisierung

Die Digitalisierungsstrategie der Arbeits- und Sozialverwaltung

- Digitalisierung & Modernisierung

- Personalwirtschaft

Migrantische Gründungen als Chance für Deutschland

- Digitalisierung & Modernisierung

- Veranstaltungen

Gemeinsam.Wissen.Nutzen – Ausländerbehörden für eine effiziente Fachkräfteeinwanderung rüsten

- Digitalisierung & Modernisierung